Big Data Accelerator + TextualETL™ = The Perfect Combination

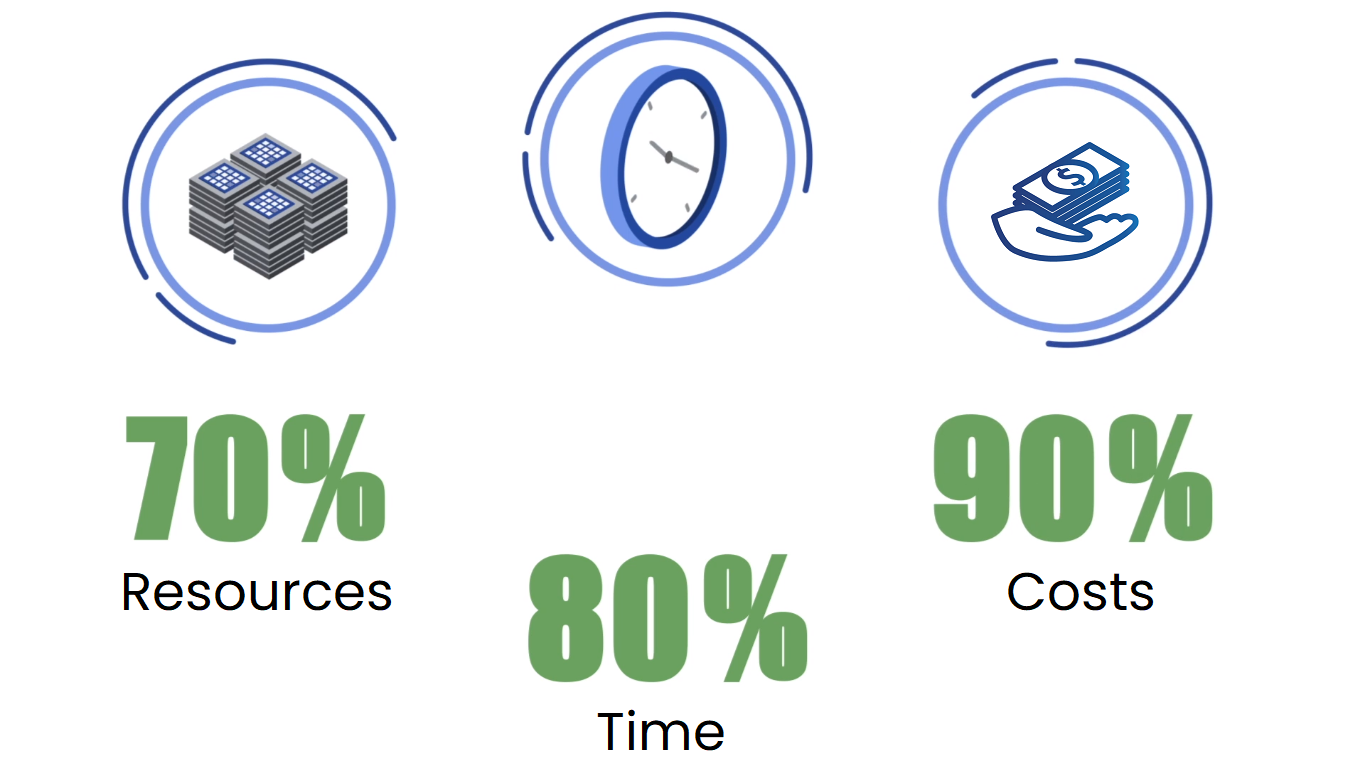

Big Data Accelerator delivers much faster results while requiring fewer hardware resources. By requiring less hardware, Big Data Accelerator helps reduce ongoing operational costs and sustainability.

TextualETL ™ from FOREST RIM® reads, integrates and prepares unstructured data ready for standard technologies such as Oracle, DB2, Teradata and NT SQL Server. Once the unstructured data resides in one of these technologies, standard analytics tools such as Business Objects, Cognos, MicroStrategy, SAS, Tableau, and other analytics and BI visualization technologies can be used to access, analyze, and display your unstructured data.

These new applications can display and retrieve textual data and address and highlight fundamental business challenges that were not previously realized.